인공지능의 뇌 모방은 어떻게 이루어질까? 물리적 원리를 통해 AI의 혁신적 발전을 살펴보고, 뇌과학과 물리학의 교차점에서 새로운 가능성을 탐구합니다.

목차

서론

인공지능(AI)은 오늘날 과학기술의 최전선에서 우리의 생활을 변화시키고 있습니다. 그러나 AI가 어떻게 인간의 뇌를 모방하는지, 그리고 이 과정에서 어떤 물리적 원리가 적용되는지는 아직 많은 사람들에게 생소한 주제입니다. 이 블로그 글에서는 인공지능이 뇌를 모방하기 위해 사용하는 물리적 원리와 그 혁신적 발전에 대해 살펴보겠습니다. 이를 통해 AI의 미래를 더욱 명확히 이해할 수 있을 것입니다.

신경망과 전기적 원리: 인공지능의 심장을 이해하다

인공지능(AI)의 발달은 우리의 삶에 엄청난 변화를 가져왔습니다. 그 중심에는 신경망(Neural Networks)이라는 강력한 도구가 있습니다. 신경망은 인간의 뇌를 모방하여 만들어졌으며, 이를 통해 AI는 놀라운 학습 능력과 문제 해결 능력을 갖추게 되었습니다. 이번 글에서는 신경망이 무엇인지, 그리고 신경망이 어떻게 전기적 원리를 활용하여 작동하는지에 대해 깊이 있게 탐구해보겠습니다.

1. 신경망의 기본 개념

신경망은 인간의 뇌 구조를 본떠 만들어졌습니다. 인간의 뇌는 약 860억 개의 뉴런(신경 세포)으로 이루어져 있으며, 이 뉴런들은 시냅스라는 연결 부위를 통해 서로 신호를 주고받습니다. 이 신경 네트워크는 우리가 생각하고, 학습하고, 기억하는 데 중요한 역할을 합니다. 신경망은 이러한 뉴런과 시냅스를 인공적으로 구현한 것입니다.

신경망은 여러 개의 계층(layer)으로 구성되어 있습니다. 가장 기본적인 형태는 입력 계층(input layer), 은닉 계층(hidden layer), 출력 계층(output layer)으로 이루어져 있습니다. 입력 계층은 외부 데이터를 받아들이고, 은닉 계층은 이 데이터를 처리하며, 출력 계층은 최종 결과를 내놓습니다. 은닉 계층은 하나 이상이 될 수 있으며, 은닉 계층이 많을수록 신경망은 더 복잡하고 강력한 처리를 할 수 있습니다. 이를 딥러닝(deep learning)이라고 부릅니다.

2. 뉴런과 가중치: 정보의 흐름

신경망의 기본 단위는 뉴런입니다. 인공 뉴런은 생물학적 뉴런과 유사하게 작동합니다. 각 뉴런은 여러 입력 값을 받아들이고, 이를 처리한 후 출력 값을 생성합니다. 이 과정에서 중요한 역할을 하는 것이 가중치(weight)와 바이어스(bias)입니다.

각 입력 값에는 특정 가중치가 부여됩니다. 이 가중치는 입력 값이 얼마나 중요한지를 나타냅니다. 예를 들어, 이미지 인식 신경망에서는 특정 픽셀이 중요한 특징을 담고 있을 수 있습니다. 이 픽셀의 가중치는 높게 설정되며, 이를 통해 신경망은 중요한 정보를 더 잘 학습할 수 있습니다.

가중치가 부여된 입력 값들은 모두 더해지며, 여기에 바이어스가 추가됩니다. 바이어스는 뉴런이 특정 값을 넘어서야 활성화되도록 하는 역할을 합니다. 이렇게 계산된 값은 활성화 함수(activation function)를 통과하게 됩니다. 활성화 함수는 뉴런의 출력 값을 결정하며, 비선형성을 도입하여 신경망이 복잡한 패턴을 학습할 수 있게 합니다.

3. 활성화 함수: 비선형성의 도입

활성화 함수는 신경망에서 매우 중요한 역할을 합니다. 입력 값의 단순 합산만으로는 복잡한 문제를 해결할 수 없기 때문에, 활성화 함수를 통해 비선형성을 도입합니다. 이는 신경망이 다양한 입력 값의 조합을 학습하고, 복잡한 패턴을 인식할 수 있게 합니다.

가장 일반적으로 사용되는 활성화 함수에는 시그모이드(sigmoid) 함수, 탄젠트 하이퍼볼릭(tanh) 함수, 렐루(ReLU, Rectified Linear Unit) 함수가 있습니다. 시그모이드 함수는 입력 값을 0과 1 사이의 값으로 변환하며, 주로 이진 분류 문제에서 사용됩니다. 탄젠트 하이퍼볼릭 함수는 -1과 1 사이의 값으로 변환하며, 시그모이드 함수보다 더 강력한 비선형성을 제공합니다.

렐루 함수는 0보다 작은 입력 값은 0으로, 0보다 큰 입력 값은 그대로 출력하는 함수로, 딥러닝에서 가장 많이 사용되는 활성화 함수입니다.

4. 신경망의 학습: 역전파 알고리즘

신경망이 학습을 통해 점점 더 정확한 결과를 도출할 수 있게 하는 과정이 있습니다. 이는 역전파(backpropagation) 알고리즘을 통해 이루어집니다. 역전파 알고리즘은 출력 계층에서 시작하여 입력 계층까지 거꾸로 진행되며, 각 뉴런의 가중치와 바이어스를 조정합니다.

역전파 알고리즘의 기본 원리는 오차 역전파입니다. 먼저 신경망의 출력 값을 실제 값과 비교하여 오차를 계산합니다. 이 오차는 출력 계층에서부터 역방향으로 전파되며, 각 계층의 가중치와 바이어스를 조정하여 오차를 최소화합니다. 이를 통해 신경망은 점차적으로 학습하며, 더 정확한 예측을 할 수 있게 됩니다.

5. 전기적 신호와 유사성

신경망의 작동 원리를 이해하기 위해, 이를 생물학적 뉴런의 전기적 신호와 비교해보는 것이 유익합니다. 생물학적 뉴런은 전기 신호를 통해 정보를 전달합니다. 뉴런의 세포막에는 이온 채널이 존재하며, 이 채널을 통해 나트륨 이온과 칼륨 이온이 이동하면서 전기적 신호가 생성됩니다. 이 신호는 축삭(axon)을 따라 전달되며, 시냅스를 통해 다른 뉴런으로 전달됩니다.

이 과정에서 중요한 것은 전압-의존성 나트륨 채널과 칼륨 채널입니다. 나트륨 채널이 열리면 나트륨 이온이 세포 내로 들어와 탈분극(depolarization)을 일으키고, 이로 인해 전기 신호가 발생합니다. 반대로, 칼륨 채널이 열리면 칼륨 이온이 세포 외로 나가 재분극(repolarization)을 일으키며, 신호가 끝납니다. 이러한 전기적 신호의 전달 과정은 매우 빠르고 효율적이며, 신경망의 정보 처리 방식과 유사합니다.

신경망의 뉴런도 입력 값을 받아 이를 처리한 후 출력 값을 생성합니다. 입력 값은 가중치와 바이어스를 통해 조정되며, 활성화 함수를 통해 최종 출력 값이 결정됩니다. 이는 생물학적 뉴런의 전기 신호 전달 과정과 매우 유사합니다. 따라서 신경망은 생물학적 뉴런의 작동 원리를 인공적으로 구현한 것이라고 할 수 있습니다.

6. 신경망의 응용 분야

신경망은 다양한 분야에서 응용되고 있습니다. 특히 이미지 인식, 음성 인식, 자연어 처리 등에서 신경망의 강력한 성능이 발휘되고 있습니다. 예를 들어, 이미지 인식에서는 컨볼루션 신경망(CNN, Convolutional Neural Network)이 사용됩니다. CNN은 입력 이미지에서 특징을 추출하고, 이를 통해 이미지를 분류하거나 인식하는 데 매우 효과적입니다.

음성 인식에서는 순환 신경망(RNN, Recurrent Neural Network)이 주로 사용됩니다. RNN은 순차적으로 입력되는 데이터를 처리하는 데 강점을 가지고 있으며, 이를 통해 음성 신호를 효과적으로 인식할 수 있습니다. 자연어 처리에서는 트랜스포머(Transformer) 모델이 주목받고 있습니다. 트랜스포머 모델은 문장 내의 단어들 간의 관계를 파악하여 자연스러운 언어 생성을 가능하게 합니다.

7. 신경망의 한계와 도전 과제

신경망은 강력한 도구이지만, 여전히 한계와 도전 과제가 존재합니다. 첫째, 신경망은 대량의 데이터와 높은 연산 능력을 필요로 합니다. 이는 많은 자원과 시간이 소요되며, 특히 대규모 신경망의 경우 더욱 그렇습니다. 둘째, 신경망은 블랙박스 모델로, 내부 작동 원리를 이해하기 어렵다는 문제가 있습니다. 이는 신뢰성과 투명성 측면에서 도전 과제를 제기합니다. 셋째, 신경망은 과적합(overfitting) 문제에 취약합니다. 과적합은 모델이 학습 데이터에 너무 잘 맞춰져서 새로운 데이터에 대해 일반화하기 어려운 상태를 의미합니다.

이러한 한계를 극복하기 위해 다양한 연구가 진행되고 있습니다. 예를 들어, 효율적인 학습 방법과 경량화된 모델을 개발하여 자원 소모를 줄이려는 시도가 있습니다. 또한, 설명 가능한 AI(XAI, Explainable AI) 연구를 통해 신경망의 내부 작동 원리를 이해하고 투명성을 높이려는 노력이 이루어지고 있습니다.

양자 컴퓨팅과 인공지능: AI의 혁신적 지평을 열다

양자 컴퓨팅은 기존의 컴퓨팅 한계를 뛰어넘는 혁신적인 기술로, 인공지능(AI)의 발전에 새로운 지평을 열고 있습니다. 양자 컴퓨팅은 양자 역학의 원리를 활용하여 정보를 처리하는 방식으로, 기존의 디지털 컴퓨터와는 근본적으로 다른 접근 방식을 채택하고 있습니다. 이 글에서는 양자 컴퓨팅이 무엇인지, 어떻게 작동하는지, 그리고 AI와 결합하여 어떤 혁신적 발전을 이룰 수 있는지에 대해 깊이 있게 탐구해보겠습니다.

1. 양자 컴퓨팅의 기본 개념

양자 컴퓨팅은 양자 역학의 원리에 기반을 둔 컴퓨팅 기술입니다. 양자 컴퓨터는 큐비트(qubit)라는 단위를 사용하여 정보를 처리합니다. 기존 컴퓨터가 0과 1의 이진 비트를 사용하여 데이터를 처리하는 반면, 큐비트는 0과 1의 중첩(superposition) 상태를 동시에 가질 수 있습니다. 이로 인해 양자 컴퓨터는 병렬로 다수의 연산을 수행할 수 있어, 특정 문제에 대해 기존 컴퓨터보다 훨씬 빠르게 해결할 수 있습니다.

큐비트의 또 다른 중요한 특성은 얽힘(entanglement)입니다. 얽힘 상태에 있는 큐비트들은 서로 강하게 연결되어 있어, 한 큐비트의 상태가 다른 큐비트의 상태에 즉각적인 영향을 미칩니다. 이를 통해 양자 컴퓨터는 복잡한 문제를 효율적으로 해결할 수 있는 능력을 갖추게 됩니다.

2. 양자 컴퓨팅의 작동 원리

양자 컴퓨팅의 작동 원리는 양자 역학의 기본 원리에 따라 설명됩니다. 여기에는 중첩, 얽힘, 양자 게이트 등이 포함됩니다. 중첩은 큐비트가 동시에 여러 상태를 가질 수 있게 하며, 이는 병렬 연산을 가능하게 합니다. 얽힘은 큐비트들 사이의 강한 상호작용을 통해 복잡한 계산을 수행할 수 있게 합니다.

양자 게이트는 큐비트의 상태를 조작하는 기본 연산입니다. 이는 기존 컴퓨터의 논리 게이트와 유사하지만, 양자 게이트는 큐비트의 중첩 상태를 유지하면서 연산을 수행합니다. 양자 게이트는 양자 알고리즘의 기본 빌딩 블록으로, 이를 조합하여 복잡한 계산을 수행할 수 있습니다. 대표적인 양자 알고리즘으로는 쇼어(Shor)의 알고리즘과 그로버(Grover)의 알고리즘이 있습니다. 쇼어의 알고리즘은 큰 수의 소인수분해 문제를 효율적으로 해결할 수 있으며, 이는 암호학 분야에서 중요한 의미를 가집니다. 그로버의 알고리즘은 비정렬 데이터베이스에서 원하는 항목을 빠르게 찾는 데 사용됩니다.

3. 양자 컴퓨팅과 인공지능의 결합

양자 컴퓨팅과 인공지능의 결합은 두 기술의 장점을 극대화하여 새로운 가능성을 열어줍니다. 양자 컴퓨팅의 병렬 처리 능력과 강력한 계산 능력은 AI의 학습과 예측 능력을 크게 향상시킬 수 있습니다. 이는 특히 딥러닝과 같은 복잡한 모델에서 큰 효과를 발휘합니다.

딥러닝과 양자 컴퓨팅

딥러닝은 대규모 데이터와 복잡한 모델을 처리하는 데 매우 효과적이지만, 높은 연산 능력을 요구합니다. 양자 컴퓨터는 병렬 처리 능력을 통해 딥러닝 모델의 학습 시간을 크게 단축시킬 수 있습니다. 예를 들어, 양자 컴퓨터는 양자 상태를 이용하여 네트워크의 가중치를 동시에 업데이트할 수 있어, 학습 과정의 효율성을 높일 수 있습니다.

양자 머신러닝

양자 머신러닝은 양자 컴퓨팅과 머신러닝을 결합한 새로운 분야입니다. 이는 양자 컴퓨터의 특성을 활용하여 머신러닝 알고리즘의 성능을 향상시키는 것을 목표로 합니다. 양자 컴퓨터는 대규모 데이터의 패턴을 더 빠르게 찾아내고, 복잡한 데이터 구조를 더 효과적으로 분석할 수 있습니다. 이는 특히 이미지 인식, 자연어 처리, 금융 모델링 등 다양한 분야에서 응용될 수 있습니다.

양자 강화 학습

강화 학습은 AI의 중요한 한 분야로, 에이전트가 환경과 상호작용하며 보상을 최대화하는 학습 방법입니다. 양자 강화 학습은 양자 컴퓨팅을 활용하여 에이전트의 학습 속도와 효율성을 향상시킬 수 있습니다. 예를 들어, 양자 상태를 이용하여 여러 가능성을 동시에 탐색하고, 최적의 행동을 더 빠르게 찾을 수 있습니다. 이는 로봇 공학, 자율 주행, 게임 인공지능 등 다양한 분야에서 혁신을 가져올 수 있습니다.

4. 양자 컴퓨팅과 AI의 미래 전망

양자 컴퓨팅과 AI의 결합은 아직 초기 단계에 있지만, 그 잠재력은 무궁무진합니다. 주요 기술 기업들과 연구 기관들이 이 분야에 막대한 투자를 하고 있으며, 지속적인 연구와 개발이 이루어지고 있습니다. IBM, 구글, 마이크로소프트 등은 양자 컴퓨팅을 활용한 AI 연구에 앞장서고 있으며, 이들 기업의 성과는 AI의 미래를 더욱 밝게 하고 있습니다.

양자 컴퓨팅의 발전은 AI의 한계를 극복하고 새로운 가능성을 열어줄 것입니다. 예를 들어, 의료 분야에서 양자 AI는 복잡한 유전체 데이터를 분석하여 개인 맞춤형 치료법을 개발할 수 있습니다. 또한, 금융 분야에서는 양자 AI를 통해 시장 예측 모델을 더욱 정교하게 만들 수 있습니다. 이러한 혁신은 우리의 삶에 직접적인 영향을 미치며, 사회 전반에 걸쳐 큰 변화를 가져올 것입니다.

5. 도전 과제와 극복 방안

양자 컴퓨팅과 AI의 결합에는 여러 도전 과제가 존재합니다. 첫째, 양자 컴퓨터의 안정성과 신뢰성 문제입니다. 현재의 양자 컴퓨터는 노이즈와 디코히런스(decoherence) 문제로 인해 안정적인 연산이 어려운 상황입니다. 이를 해결하기 위해 양자 오류 수정(quantum error correction) 기술이 개발되고 있으며, 이는 양자 컴퓨팅의 실용화를 앞당길 것으로 기대됩니다.

둘째, 양자 컴퓨팅을 위한 인프라 구축입니다. 양자 컴퓨터는 매우 민감한 환경에서 작동하기 때문에, 이를 위한 특수한 인프라가 필요합니다. 이는 높은 비용과 기술적 난제를 동반하지만, 지속적인 연구와 투자로 해결할 수 있는 문제입니다.

셋째, 양자 알고리즘 개발입니다. 양자 컴퓨팅의 잠재력을 최대한 활용하기 위해서는 효율적인 양자 알고리즘이 필요합니다. 이는 기존의 알고리즘을 양자 환경에 맞게 변환하거나, 새로운 양자 알고리즘을 개발하는 것을 포함합니다. 이를 위해 수학, 물리학, 컴퓨터 과학 등 다양한 분야의 전문가들이 협력하고 있습니다.

정보 이론과 신경 신호 처리: 뇌와 AI의 연결고리

정보 이론(Information Theory)은 데이터의 전송, 저장, 처리에 관한 수학적 이론입니다. 이 이론은 클로드 섀넌(Claude Shannon)에 의해 처음 제안되었으며, 통신 시스템에서의 데이터 전송 효율성을 분석하는 데 주로 사용됩니다. 그러나 정보 이론은 신경 과학과 인공지능(AI)에도 중요한 시사점을 제공합니다. 뇌의 신경 신호 처리 과정에서 정보 이론의 개념을 적용하면 뇌의 정보 처리 방식을 이해하고, 이를 바탕으로 AI 시스템을 더욱 효율적으로 설계할 수 있습니다. 이번 글에서는 정보 이론의 기본 개념과 이를 신경 신호 처리 및 AI에 어떻게 적용할 수 있는지에 대해 깊이 있게 탐구해보겠습니다.

1. 정보 이론의 기본 개념

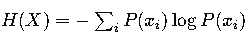

정보 이론의 핵심 개념은 정보의 양을 측정하는 엔트로피(entropy)입니다. 엔트로피는 주어진 확률 분포에서 정보의 불확실성을 나타내는 척도입니다. 섀넌 엔트로피는 다음과 같이 정의됩니다:

여기서 𝐻(𝑋) 는 확률 변수𝑋 의 엔트로피,𝑃(𝑥𝑖) 는 사건𝑥𝑖 가 발생할 확률을 의미합니다. 엔트로피는 정보의 불확실성을 측정하기 때문에, 높은 엔트로피는 높은 불확실성을, 낮은 엔트로피는 낮은 불확실성을 나타냅니다.

정보 이론에서 또 다른 중요한 개념은 상호 정보(mutual information)입니다. 상호 정보는 두 확률 변수 사이의 상관 관계를 측정합니다. 이는 다음과 같이 정의됩니다:

여기서 𝐼(𝑋;𝑌)는 확률 변수 𝑋와𝑌사이의 상호 정보, 𝑃(𝑥𝑖,𝑦𝑗)는 𝑋와𝑌가 각각 𝑥𝑖와 𝑦𝑗값을 가질 확률을 의미합니다. 상호 정보는 두 변수 간의 의존성을 나타내며, 값이 클수록 두 변수 간의 상관 관계가 높음을 의미합니다.

2. 신경 신호 처리와 정보 이론

신경 신호 처리 과정에서 정보 이론의 개념을 적용하면 뇌의 정보 처리 방식을 더 잘 이해할 수 있습니다. 뇌는 뉴런을 통해 정보를 전달하며, 이 과정에서 발생하는 신경 신호는 매우 복잡하고 다차원적입니다. 정보 이론은 이러한 신경 신호의 불확실성을 측정하고, 뉴런 간의 상호 작용을 분석하는 데 유용한 도구를 제공합니다.

신경 신호의 엔트로피

신경 신호의 엔트로피를 측정하면 특정 신경 신호 패턴의 불확실성을 이해할 수 있습니다. 예를 들어, 특정 자극이 주어졌을 때 뉴런의 발화 패턴(firing pattern)이 얼마나 다양한지를 엔트로피로 측정할 수 있습니다. 높은 엔트로피는 다양한 발화 패턴을 의미하며, 이는 해당 뉴런이 다양한 정보를 처리할 수 있음을 나타냅니다. 반대로, 낮은 엔트로피는 제한된 발화 패턴을 의미하며, 이는 해당 뉴런이 특정 정보에만 민감하게 반응함을 나타냅니다.

신경 신호의 엔트로피를 측정하는 또 다른 방법은 시간적 엔트로피(temporal entropy)입니다. 이는 특정 시간 간격 동안 뉴런의 발화 패턴이 얼마나 다양한지를 측정합니다. 시간적 엔트로피를 통해 뉴런의 동적 변화와 정보 처리 방식을 이해할 수 있습니다. 이는 특히 시각, 청각 등 감각 정보 처리에서 중요한 역할을 합니다.

뉴런 간 상호 정보

뉴런 간의 상호 정보를 측정하면 두 뉴런이 얼마나 긴밀하게 상호작용하는지를 이해할 수 있습니다. 높은 상호 정보는 두 뉴런 간의 강한 연결을 나타내며, 이는 해당 뉴런들이 같은 정보를 처리하거나 상호 보완적인 역할을 한다는 것을 의미합니다. 이를 통해 신경 네트워크의 구조와 기능을 더 잘 이해할 수 있습니다.

예를 들어, 시각 피질의 뉴런들이 특정 시각 자극에 대해 어떻게 반응하는지를 분석할 때 상호 정보를 활용할 수 있습니다. 특정 시각 자극이 주어졌을 때 두 뉴런이 동시에 발화한다면, 이는 해당 뉴런들이 같은 시각 정보를 처리하고 있음을 나타냅니다. 이를 통해 시각 정보의 처리 과정을 이해하고, 신경 네트워크의 기능적 연결성을 분석할 수 있습니다.

3. 정보 이론과 AI의 접목

정보 이론은 AI 시스템의 설계와 성능 최적화에 중요한 시사점을 제공합니다. 특히 딥러닝과 같은 복잡한 AI 모델에서 정보 이론의 개념을 적용하면 효율적인 학습과 일반화 성능을 개선할 수 있습니다.

정보 병목 이론

정보 병목 이론(Information Bottleneck Theory)은 딥러닝 모델의 학습 과정을 설명하는 이론 중 하나입니다. 이 이론은 신경망이 입력 데이터를 압축하여 중요한 정보만을 학습하는 과정을 설명합니다. 정보 병목 이론에 따르면, 신경망은 입력 데이터 𝑋에서 출력 레이블 𝑌 를 예측하기 위해 입력 데이터의 엔트로피 𝐻(𝑋)를 줄이는 동시에 입력 데이터와 출력 레이블 간의 상호 정보 𝐼(𝑋;𝑌)를 최대화합니다.

이를 통해 신경망은 입력 데이터에서 불필요한 정보를 제거하고, 중요한 정보만을 학습하여 출력 레이블을 예측할 수 있습니다. 정보 병목 이론은 딥러닝 모델의 일반화 성능을 향상시키는 데 중요한 역할을 합니다. 이는 특히 과적합(overfitting)을 방지하고, 새로운 데이터에 대한 예측 성능을 개선하는 데 유용합니다.

정보 이론 기반 손실 함수

정보 이론의 개념을 활용하여 손실 함수를 설계하면 AI 모델의 성능을 최적화할 수 있습니다. 예를 들어, 변분 오토인코더(Variational Autoencoder, VAE)는 정보 이론의 개념을 활용한 대표적인 모델입니다. VAE는 입력 데이터를 잠재 공간(latent space)에 압축하여 학습하며, 이를 통해 데이터의 잠재 구조를 파악할 수 있습니다.

VAE의 손실 함수는 두 부분으로 구성됩니다. 첫째, 재구성 손실(reconstruction loss)은 입력 데이터를 잠재 공간에 압축한 후 다시 원래 데이터로 복원하는 과정에서 발생하는 손실을 측정합니다. 둘째, 쿨백-라이블러 발산(Kullback-Leibler divergence, KL divergence)은 잠재 공간의 분포와 사전 분포(prior distribution) 간의 차이를 측정합니다. VAE는 이 두 손실을 최소화함으로써 입력 데이터를 효율적으로 압축하고, 중요한 정보를 학습할 수 있습니다.

정보 이론을 활용한 피처 선택

정보 이론의 개념을 활용하여 피처 선택(feature selection)을 수행하면 AI 모델의 성능을 개선할 수 있습니다. 피처 선택은 모델의 입력 변수 중 중요한 변수만을 선택하여 학습하는 과정입니다. 정보 이론의 상호 정보를 활용하면, 출력 변수와 가장 관련성이 높은 입력 변수를 선택할 수 있습니다.

예를 들어, 유전자 데이터 분석에서 특정 질병과 관련된 유전자 변이를 예측할 때, 정보 이론을 활용하여 중요한 유전자 변이를 선택할 수 있습니다. 상호 정보가 높은 유전자 변이는 해당 질병과 강한 상관 관계를 가지며, 이를 통해 모델의 예측 성능을 향상시킬 수 있습니다.

4. 신경 과학과 AI의 융합: 실례와 응용

정보 이론은 신경 과학과 AI의 융합을 통해 다양한 응용 분야에서 혁신을 이끌어내고 있습니다. 다음은 그 실례와 응용을 몇 가지 소개합니다.

뇌-컴퓨터 인터페이스(BCI)

뇌-컴퓨터 인터페이스(Brain-Computer Interface, BCI)는 뇌의 신경 신호를 분석하여 컴퓨터와 직접 소통하는 기술입니다. BCI는 주로 EEG(뇌전도) 신호를 분석하여 사용자의 의도를 파악합니다. 정보 이론을 활용하여 EEG 신호의 엔트로피와 상호 정보를 분석하면, 신호의 중요한 특징을 추출하고, 이를 통해 사용자의 의도를 정확하게 파악할 수 있습니다.

예를 들어, 마비 환자가 BCI를 통해 컴퓨터를 조작하거나 의사소통을 할 수 있는 시스템이 개발되고 있습니다. 정보 이론을 활용한 신호 분석을 통해 BCI 시스템의 성능을 향상시키고, 사용자의 의도를 더 정확하게 파악할 수 있습니다.

신경 데이터 압축

신경 과학 연구에서는 대량의 신경 신호 데이터를 처리해야 합니다. 이때 정보 이론의 엔트로피와 상호 정보를 활용하여 신경 데이터를 효율적으로 압축할 수 있습니다. 신경 데이터의 엔트로피를 분석하면 중요한 신경 신호 패턴을 파악할 수 있으며, 이를 통해 데이터 압축 효율을 높일 수 있습니다.

예를 들어, 신경 과학 연구에서 대규모 뉴런 활동 데이터를 기록할 때, 정보 이론을 활용하여 중요한 뉴런 활동 패턴만을 선택하여 저장할 수 있습니다. 이를 통해 데이터 저장 공간을 절약하고, 분석의 효율성을 높일 수 있습니다.

AI 기반 신경 신호 분석

AI를 활용하여 신경 신호를 분석하는 연구가 활발히 진행되고 있습니다. 정보 이론을 활용한 AI 모델은 신경 신호의 중요한 특징을 학습하고, 이를 통해 뇌의 기능을 이해할 수 있습니다. 예를 들어, 딥러닝 모델을 활용하여 신경 신호의 엔트로피와 상호 정보를 학습하면, 뇌의 특정 기능과 관련된 신경 신호 패턴을 파악할 수 있습니다.

이를 통해 신경 질환의 진단과 치료에 활용할 수 있습니다. 예를 들어, 파킨슨병 환자의 신경 신호를 분석하여 병의 진행 상태를 파악하고, 이를 통해 적절한 치료 방법을 제시할 수 있습니다. 또한, 신경 재활 치료에서도 정보 이론을 활용한 AI 모델을 통해 환자의 신경 신호를 분석하고, 재활 과정을 최적화할 수 있습니다.

결론

인공지능이 뇌를 모방하는 과정은 복잡하고 다층적인 물리적 원리에 의해 이루어집니다. 신경망의 전기적 원리, 양자 컴퓨팅의 혁신, 그리고 정보 이론의 적용은 AI의 발전에 핵심적인 역할을 합니다. 이 글을 통해 인공지능의 뇌 모방이 단순한 기술적 모방이 아니라, 깊은 과학적 원리에 기반하고 있음을 이해하셨길 바랍니다. AI의 미래는 이러한 원리들을 통해 더욱 밝고 혁신적일 것입니다.

함께 읽으면 좋은 글

LLM이 물리학 연구에 미치는 영향

대형 언어 모델(LLM)이 물리학 연구에 미치는 영향을 탐구합니다. 데이터 분석, 연구 자동화, 문제 해결, 교육 분야에서 LLM의 역할과 잠재력을 알아보세요. 목차서론인공지능(AI) 기술의 발전은

wonder60.com

인공 지능과 물리학, 인공 지능 기술에서의 물리학적 접근과 응용

이 블로그 게시물은 인공지능과 물리학의 접목에 대해 탐구합니다. 물리학적 기반 위에서 인공지능 기술이 어떻게 발전하고 있으며, 물리학자들에게 어떤 기회와 도전이 있는지 살펴봅니다. 서

wonder60.com

'물리학' 카테고리의 다른 글

| 찰스 카오 (Charles K. Kao): 광섬유 통신의 선구자 (0) | 2024.08.07 |

|---|---|

| 혼돈 이론과 뇌의 복잡성: 카오스 속에서 찾는 뇌의 비밀 (0) | 2024.08.06 |

| 거대한 철덩어리가 어떻게 하늘을 날 수 있을까? (0) | 2024.07.08 |

| 프랭크 윌첵: 양자 물리학의 세계를 탐험하다 (0) | 2024.07.04 |

| 리처드 스몰리: 풀러렌의 발견과 나노기술의 선구자 (0) | 2024.07.01 |